Sommaire

L’indexation est une étape fondamentale dans toute stratégie d’optimisation SEO. Pour faciliter la circulation des robots d’exploration des moteurs de recherche, ou au contraire pour les empêcher d’accéder à certaines URL, les référenceurs disposent de plusieurs outils en complément des balises <meta robots> positionnées entre balises <head> :

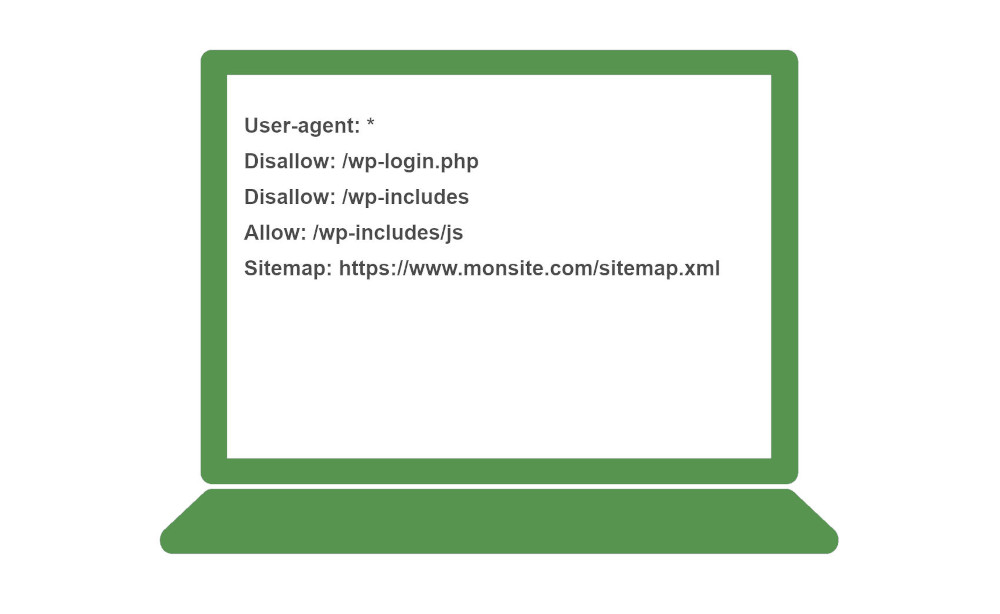

- le fichier robots.txt pour demander aux moteurs de recherche de ne pas indexer certaines URL, certains répertoires ou types de contenus;

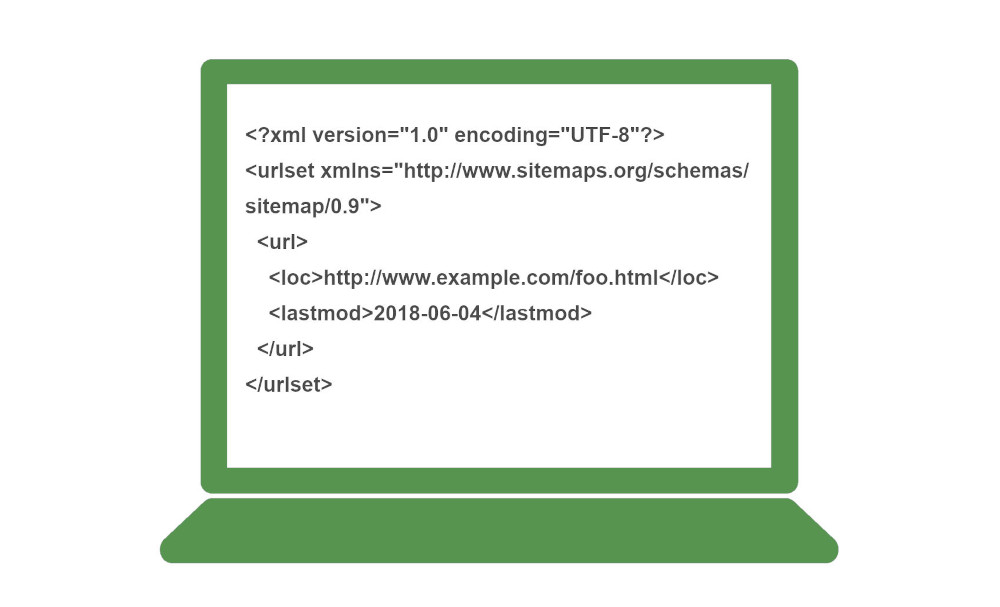

- le fichier sitemap pour lister les URL à explorer (pages web, images, vidéos, actualités, variantes internationales d’un même contenu,etc.).

Le fichier robots.txt

Ce fichier au format .TXT porte toujours le même nom et se positionne :

- à la racine de votre site

par exemple : https://www.benjaminthiers.net/robots.txt - à la racine d’un sous-domaine

par exemple : https://larandonnee.wixsite.com/robots.txt

Il est donc très facile à trouver pour les moteurs de recherche. Il suffit :

- de lui donner le bon nom

- de le mettre au bon emplacement

La vocation du fichier robots.txt

Le fichier robots.txt s’adresse uniquement aux robots d’indexation des moteurs de recherche. On pourrait le comparer fichier à un panneau d’informations à l’entrée d’un campus, qui renseignerait le visiteur sur les bâtiments autorisés, et ceux qui ne sont normalement pas accessibles au public.

Quand un robot d’exploration se rend sur votre site web, il commence toujours par vérifier la présence d’un fichier robots.txt. Si celui-ci existe, le moteur de recherche prend connaissance des URL ou des répertoires qui lui sont pas autorisés.

Le fichier robots.txt permet d’optimiser l’exploration (crawl) en évitant au Googlebot et aux autres robots de perdre du temps sur des pages web non pertinentes. Mais il n’empêche pas l’indexation de votre URL : pour cela, rien ne vaut la balise <meta name=”robots” content=”noindex” /> placée entre les balises <head></head> pour chaque page web concernée.

Les principales fonctionnalités du robots.txt

Vous pouvez demander à ne pas explorer :

- une URL (page web, image, fichier, etc.)

- un répertoire (/admin/ ou /archives/)

- une séquence de caractères (toutes les URL avec la séquence search)

- une extension (tous les fichiers PDF)

Vous pouvez aussi y préciser l’adresse de votre fichier sitemap.

Vous pouvez vous adresser, pour chaque directive :

- à tous les robots d’exploration

- à un robot en particulier (Googlebot, Bingbot, etc.)

Le fichier sitemap

Vous pouvez comparer un fichier sitemap à une liste d’URL fournie aux moteurs de recherche. Ils peuvent ainsi connaître plus facilement les pages web, les images, les vidéos ou encore les actualités qu’ils peuvent explorer et indexer.

Le format XML est le plus fréquemment rencontré, mais il n’est pas obligatoire.

Vous pouvez déclarer l’existence de vos sitemaps grâce :

- au fichier robots.txt (tous les moteurs de recherche)

- à Google Search Console (uniquement pour Google)

En soumettant votre fichier sitemap sur Google Search Console, vous serez informé des éventuelles erreurs.

La vocation du sitemap

Ce fichier a pour vocation première d’informer les moteurs de recherche des URL à explorer en vue d’une indexation. il joue un rôle informatif : ce n’est pas parce qu’une page web figure par exemple dans votre fichier sitemap qu’elle sera forcément explorée et indexée.

Vous pouvez aussi y préciser les différentes versions linguistiques ou locales de vos pages web dans le cadre d’une stratégie de référencement international.

Différents types de fichiers sitemaps

Vous pouvez créer des sitemaps pour plusieurs types de contenus :

- pages web

- images

- vidéos

- actualités