Sommaire

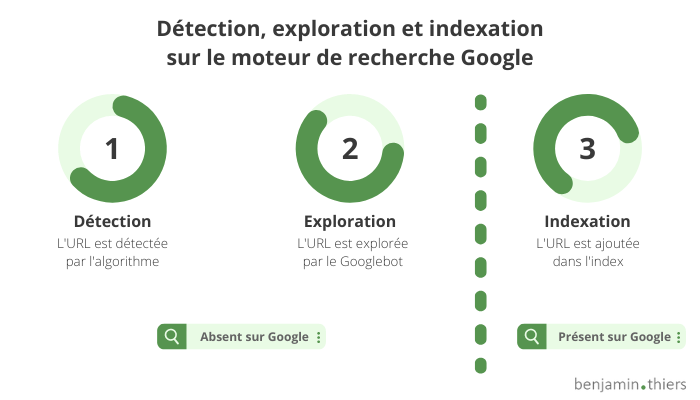

Quand vous effectuez une recherche sur Internet, vous ne recherchez pas sur le web. Les moteurs ne peuvent pas parcourir le web en temps réel, cela est tout simplement impossible ! En réalité, Google et ses concurrents parcourent en temps réel internet, en quête de nouvelles pages web, d’images, de vidéos, de documents à proposer à leurs utilisateurs. ils utilisent pour cela des bots, qu’on appelle aussi robots d’indexation, crawlers ou encore spiders.

Les contenus jugés pertinents et de qualité sont ainsi stockés dans d’immenses bases de données et revisités régulièrement. Quand un internaute effectue une recherche, c’est dans cet index que Google, Bing, Qwant, Yandex ou encore Baïdu vont chercher leurs résultats.

Un référenceur n’ignore pas ce processus. Faciliter l’exploration de vos contenus, et favoriser l’indexation de vos pages, images, vidéos et documents dans les bases de donnée des moteurs de recherche font partie de la base du référencement naturel.

L’exploration de vos contenus

Le processus d’exploration est la première étape de tout référencement de site web. Si vos contenus ne sont pas connus de Google, Bing ou encore Yandex et Baidu, comment pourraient-ils être référencés et à plus forte raison être positionnés ? Si permettre l’exploration du Googlebot et des autres robots d’exploration (crawlers) est un prérequis , l’optimisation de ce processus de “crawl” est un véritable levier SEO qui peut parfois faire la différence.

Des URL détectées par les robots des moteurs

Le premier élément clé pour favoriser l’indexation d’un site est l’accessibilité de vos URL. Pour que Google (ou un autre moteur de recherche) puisse visiter votre page et amorcer le processus de référencement, il doit connaître son URL.

Plusieurs points d’entrée permettent à un crawler de détecter un contenu :

- les liens internes sont à la base de toute stratégie de référencement naturel. Le Googlebot (ou autre crawler) suit les liens de votre menu, de votre footer, ou ceux directement glissés dans vos contenus.

- le sitemap est un fichier qui recense une liste d’URLs de votre site ouvertes à l’exploration et à l’indexation. Vous pouvez créer un sitemap pour vos pages, pour vos images, pour vos vidéos et pour vos actualités.

- les liens externes peuvent aussi contribuer à l’accessibilité de vos URL. Les robots suivent les liens externes, et passent ainsi de site en site.

- des outils permettent de demander l’exploration d’une page. Google Search Console, par exemple, permet de demander l’exploration (et l’indexation) d’une URL.

| Le concept de page orpheline |

|---|

Une page orpheline est une page web vers laquelle aucun lien ne pointe depuis votre propre site. Elle n’est maillée ni en menu principal, ni dans un lien intext ou dans un menu contextuel. Si Google (ou un autre moteur) peut finir par la découvrir, elle ne sera que très peu fréquemment explorée. |

Un code source lisible et compréhensible

Les algorithmes des moteurs de recherche rencontrent parfois des difficultés pour lire le code source de votre page web. Certains langages, bien que de mieux en mieux compris, peuvent ralentir le processus d’exploration.

Par exemple, un site développé en client side rendering (CSR ou rendu côté client) et reposant sur du JavaScript peut être exploré et indexé… Mais les ressources requises pour interpréter le JS sont supérieures à celles nécessaires pour du code HTML, et le processus d’exploration peut en être altéré.

Par défaut, les sites en server side rendering (SSR ou rendu côté serveur) et reposant sur le couple HTML / CSS ne pose pas de problèmes particuliers pour l’exploration par le Googlebot et les autres spiders.

L’indexation de vos contenus

Le Googlebot (ou autre robot) a exploré votre contenu ? L’algorithme peut le mettre en cache. Cela signifie qu’il est stocké sur un serveur (ou datacenter), et qu’il peut être proposé dans les résultats pour répondre à la recherche d’un internaute.

Un contenu digne d’intérêt

Les moteurs, Google en tête, désirent proposer des contenus qui répondent aux intentions de recherche de leurs utilisateurs. Des contenus de qualité, qui apportent aux internautes les réponses ou les fonctionnalités attendues.

Pour améliorer l’indexation de votre site web, vous devez vous assurer que chaque page indexable propose un contenu original, qui valorise le champ lexical associé à la sémantique de l’expression travaillée.

Le respect des règles déontologiques

Certaines pratiques sont prohibées par les moteurs de recherche. Si vous les utilisez, vos contenus pourraient tout simplement ne pas être indexés, même s’ils sont explorés.

En respectant les règles déontologiques édictées par Google, vous n’aurez pas à vivre sous le couperet d’une désindexation ou d’une relégation dans les tréfonds du classement.

La prise en compte des critères de pertinence

D’autres critères de pertinence liés aux algorithmes peuvent limiter l’indexation de vos contenus. Un site trop lent, par exemple, sera potentiellement moins bien crawlé (et donc indexé) qu’un site rapide. De même, un site non mobile friendly peut voir son indexation impactée défavorablement.

Améliorez votre fréquence de crawl pour un meilleur référencement

Être exploré, c’est bien. Être indexé, c’est mieux. Mais être régulièrement revisité, et offrir à Google et consorts des versions récentes en cache de vos pages, c’est encore mieux ! En effet, une version récente en cache est un gage de qualité, car la version sur laquelle Google s’appuie pour ses résultats a plus de probabilités de ne pas avoir changé si le cache est récent. Plusieurs stratégies vous permettent d’améliorer votre taux de crawl.

| La définition du taux de crawl |

|---|

Le taux de crawl désigne la fréquence à laquelle un moteur de recherche explore votre site, et correspond au ratio entre le nombre total de pages et le nombre de pages crawlées sur une période donnée. Par exemple, un site qui compte 100 pages, et dont 30 pages sont crawlées chaque mois, présente un taux de crawl mensuel de 30%. Vous pouvez affiner votre analyse du taux de crawl par type de page (catégorie, produits e-commerce, articles de blog, etc.), ou par niveau de profondeur. |

Travaillez l’animation éditoriale de votre site web

Un site régulièrement enrichi avec de nouveaux contenus est généralement visité plus souvent par un moteur de recherche.

En effet, les moteurs comme Google possèdent des ressources limitées, et se voient proposer une quantité croissante de sites internet. Ils vont donc visiter moins souvent des sites qui ne proposent pas régulièrement de nouveaux contenus ou des modifications éditoriales. À l’inverse, un site régulièrement mis à jour va proposer à chaque fois des nouveautés, et va donc être crawlé plus souvent.

Je vous conseille d’animer de façon régulière et constante votre site : privilégiez par exemple la publication d’un contenu par semaine, à la mise en ligne de 5 contenus en une fois à la fin du mois.

Analysez le maillage interne avec un crawler

Pour vous assurer de la qualité de votre maillage interne, vous pouvez utiliser un outil de type crawler. Ces solutions reproduisent le comportement des robots des moteurs de recherche, et parcourent l’ensemble des pages auxquelles ils ont accès.

Vous pourrez ainsi vous assurer que vos pages stratégiques sont bien maillées, avec un :

- grand nombre de liens internes (pour apporter un meilleur Page Rank interne)

- niveau de profondeur faible (nombre de clics minimum qui sépare une page de la page d’accueil

- maillage renforcé et des pages de thématique similaire (logique de silo sémantique ou de topic cluster)

Suivez le processus d’exploration avec Google Search Console

Vous pouvez détecter d’éventuels problèmes d’exploration dans la catégorie Index :

- Couverture : idéal pour découvrir les erreurs serveur (500, 501, 502, 503, etc.), les redirections (301, 302, etc.), les liens cassés (404, 410, etc.), ou encore les pages exclues par le robots.txt ou une balise spécifique.

- Sitemap : si des sitemaps présentent des erreurs, vous en serez informé ici.

Pour approfondir le sujet, je vous renvoie vers le dossier consacré à Google Search Console.

Améliorez le temps de chargement de vos pages

Un temps de chargement exagéré peut aussi dégrader votre taux de crawl en retardant le processus d’exploration. Et la performance fait de plus partie des critères de pertinence SEO, et est au coeur de la Google Page Experience.

Je vous invite à contrôler le temps de chargement de vos pages :

- sur Google Search Console : rendez-vous sur Expérience, et Signaux Web Essentiels, pour découvrir les URL dont les performances sont dégradées.

- sur PageSpeed Insights : cet outil gratuit de Google fournit des indicateurs de performance pour l’URL de votre choix. Testez au moins une page par type de template disponible sur votre site (par exemple, la home page, une page catégorie, une page produit, etc.). Lien : https://pagespeed.web.dev/?hl=fr

| Contrôlez la version en cache de vos pages |

|---|

Vous souhaitez vous assurer que Google indexe bien vos pages, et prend en compte l’intégralité du contenu ? Vous pouvez taper l’opérateur de commande cache:https://www.monsite.com/mapage.html dans Google ou dans la barre d’adresse du navigateur (si Google est le moteur défini par défaut) pour afficher le cache. Il ne vous reste plus qu’à choisir “Version en Texte Seul” pour vous concentrer sur le contenu éditorial. Vous pouvez aussi vous rendre dans Google Search Console et utiliser la fonctionnalité Inspection de l’URL : vous saisissez une URL de votre site, et vous cliquez sur Afficher la page explorée. |